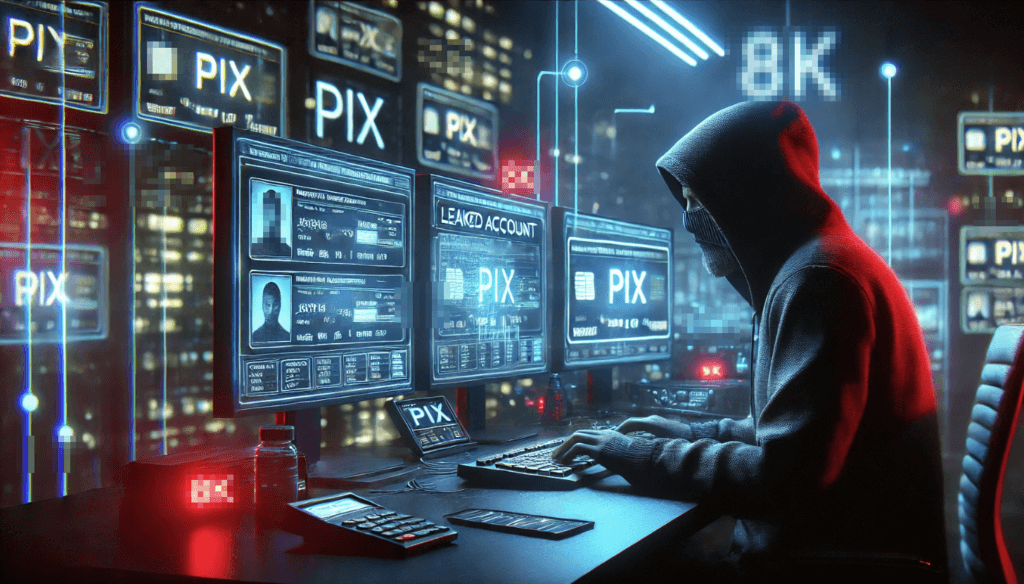

O uso de inteligência artificial generativa está prestes a mudar drasticamente a paisagem do cibercrime. Um novo relatório divulgado pela DCiber revela um dado alarmante: cerca de 50% dos golpes do tipo phishing em 2025 utilizarão vozes sintéticas para enganar as vítimas. Trata-se de um cenário que aponta para uma revolução silenciosa e perigosa na forma como criminosos digitais abordam suas vítimas — cada vez mais convincentes, rápidos e difíceis de identificar.

Esses ataques, antes centrados em e-mails fraudulentos ou mensagens de texto, evoluíram para algo mais sofisticado. Utilizando modelos de IA generativa treinados para imitar vozes humanas com alta precisão, os criminosos conseguem criar áudios realistas com base em poucos segundos de gravação. Vídeos de redes sociais, áudios em aplicativos de mensagem ou participações em podcasts e entrevistas públicas fornecem material suficiente para a clonagem de voz.

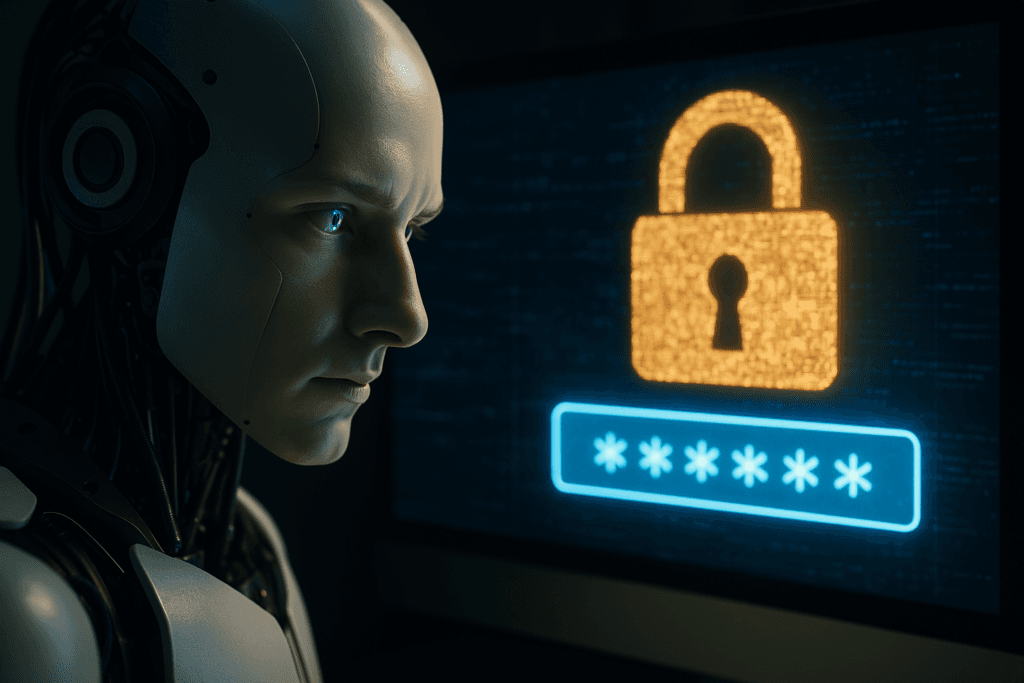

O resultado é a capacidade de gerar chamadas falsas nas quais a vítima acredita estar conversando com um gestor da empresa, colega de trabalho, familiar ou até um representante bancário — todos forjados por IA. Em muitos casos, a voz simulada faz pedidos urgentes de transferência, compartilhamento de senhas ou códigos de autenticação. E o pior: tudo isso com uma entonação emocional e familiar que quebra a desconfiança do interlocutor.

Por que golpes com voz sintética são tão perigosos?

A principal força desse tipo de golpe está na quebra da barreira psicológica que ainda existia em outras formas de phishing. Quando uma vítima lê uma mensagem suspeita, ela tende a desconfiar do conteúdo, da grafia ou do remetente. Mas quando ouve a voz de alguém de confiança, a barreira de segurança é rapidamente derrubada, abrindo espaço para decisões impulsivas.

É por isso que a engenharia social — conjunto de técnicas que explora o comportamento humano para obter acesso a informações confidenciais — ganha uma nova dimensão com a clonagem de voz. O áudio se torna a arma mais eficaz, substituindo links duvidosos por comandos de voz personalizados, emocionais e persuasivos.

Casos reais já estão acontecendo

Nos últimos dois anos, casos de golpes com voz sintética vêm crescendo silenciosamente. Um exemplo emblemático foi o de um executivo europeu que transferiu US$ 243 mil após receber uma ligação falsa do CEO da empresa, cuja voz foi clonada por IA. Em outro episódio, uma funcionária de RH de uma grande empresa foi convencida a fornecer dados bancários após ouvir a suposta voz de seu gerente solicitando acesso “emergencial”.

No Brasil, ainda são poucos os relatos públicos, mas especialistas alertam que o terreno está fértil para a disseminação desse tipo de crime, dada a popularidade das redes sociais, a baixa cultura em cibersegurança e o avanço acelerado das ferramentas de IA.

Como se proteger?

A recomendação dos especialistas é clara: a prevenção começa pela informação. Empresas precisam investir em treinamentos de conscientização sobre cibersegurança, especialmente sobre golpes que envolvem engenharia social e IA generativa. É necessário estabelecer protocolos rigorosos de verificação de identidade, mesmo quando as solicitações parecerem legítimas ou vierem de pessoas conhecidas.

No âmbito corporativo, deve-se implementar políticas de múltiplos níveis de autenticação e criar canais de comunicação seguros e validados para transferências e decisões sensíveis. Além disso, funcionários devem ser orientados a não compartilhar conteúdos de voz em ambientes públicos ou redes sociais, já que isso pode servir como insumo para a clonagem vocal.

No contexto individual, o ideal é sempre confirmar ligações suspeitas por outros meios — como mensagens escritas, chamadas de retorno ou contato direto com a pessoa envolvida. Nunca se deve fornecer informações sensíveis por telefone sem uma validação adicional.

Educação e investimento em segurança digital são cruciais

Esse novo cenário exige uma mudança de mentalidade urgente. Não basta mais atualizar o antivírus ou evitar clicar em links duvidosos — é preciso entender que a tecnologia agora imita emoções, vozes e vínculos sociais. A prevenção contra esses crimes passa por educação digital constante, conscientização coletiva e, principalmente, investimento em segurança cibernética.

Para empresas e gestores, isso significa deixar de tratar a segurança como um custo e passar a vê-la como parte estratégica da operação. Da mesma forma, governos e instituições educacionais precisam incorporar o tema em suas agendas e currículos, preparando cidadãos para lidar com os desafios da era digital.

A expectativa é que o uso de IA generativa em crimes digitais não pare por aí. Deepfakes de vídeo, mensagens personalizadas em tempo real e perfis falsos hiper-realistas já estão sendo desenvolvidos e utilizados. Assim, reforçar a confiança digital e criar barreiras éticas e tecnológicas contra o mau uso da IA é, mais do que nunca, uma prioridade global.

O que esperar do futuro?

Especialistas apontam que os próximos anos serão decisivos para o combate a esse novo tipo de ameaça. Tecnologias de detecção de deepfakes, soluções de autenticação por biometria comportamental e sistemas de alerta automatizados já estão em desenvolvimento, mas sua eficácia depende da adoção em larga escala e da educação do usuário final.

O mundo caminha para um ponto em que a fronteira entre o que é real e o que é artificial se torna cada vez mais difícil de distinguir. E, enquanto isso acontece, golpistas já estão se adaptando, testando novas formas de fraudar sistemas, burlar emoções humanas e enganar até os mais experientes.

Nesse contexto, o conhecimento é a maior defesa. A era digital exige vigilância constante, aprendizado contínuo e, principalmente, uma cultura de segurança enraizada em todos os níveis — do indivíduo à organização.